人工知能(AI)がビジネスから研究まで幅広い分野で急速に進化し続ける中、プログラミング言語としてのPythonはその中心的役割を担っています。特にここ数年、AIの大衆化や生成AIの登場(ChatGPTやStable Diffusionなど)に伴って、Pythonの需要はますます加速しています。

では、なぜ数あるプログラミング言語の中でもPythonがここまで広く支持され、AIプロジェクトの第一選択肢となっているのでしょうか?

本記事では、2024年から2025年の最新動向を踏まえてその理由を深掘りしつつ、Pythonが万能ではない点にも触れ、他言語(JuliaやRustなど)との関係性についても整理して解説します。

この記事を読むことで、PythonがAI開発で選ばれる具体的な理由と最新トレンドを理解できるほか、今後のAI開発の方向性や言語選定のポイントについても明確に把握することができます。

PythonとAIの関係

人工知能(AI)開発の分野で、Pythonは事実上の標準言語として位置づけられています。過去数年で機械学習やデータサイエンスが急速に普及する中、その簡潔な構文と豊富なライブラリ群によって、PythonはAI研究者や開発者から圧倒的な支持を得てきました。

実際、2024年にはPythonがGitHub上で最も人気のある言語となり、JavaScriptを追い抜いたことが報告されています。これは、GitHub上でデータサイエンスや機械学習関連のプロジェクトが爆発的に増加していることを示す象徴的な出来事です。AIブームに伴い、新規参入者も含め世界中の開発者がPythonを用いてAIプロジェクトに取り組んでおり、その結果としてPythonはAI開発の中心的存在となっています。

Pythonの人気は、Jupyter Notebook(主にPythonで利用)の利用急増にも表れています。上のグラフは、GitHub上でJupyter Notebookを含む公開リポジトリ数の推移を示したものです。

2018年以降Notebook利用が顕著に伸び、特に2022年から2023年にかけて170%以上も急増しています。これは研究用途やプロトタイピングでPythonが広く使われている現状を物語っています。こうした背景(簡単に試行錯誤できるNotebook環境の普及など)も相まって、PythonはAI開発で重要視されるに至りました。

PythonのAI開発における強み

PythonがこれほどAI分野で支持される最大の理由は、その言語としての扱いやすさと生産性にあります。Pythonの文法は平易で可読性が高く、初心者でも習得しやすい上に、プロトタイピングやスクリプト開発を高速に行うことができます。複雑なアルゴリズム実装であっても、コードを簡潔に記述できるため開発の迅速化につながります。また、用途ごとに豊富なライブラリが整備されており、専門的な知識がなくても高度な機能を呼び出せる点も魅力です。

たとえばNumPyやpandasによるデータ処理、scikit-learnによる機械学習アルゴリズム、TensorFlowやPyTorchといったディープラーニングフレームワークなど、挙げだせばキリがないほど多彩なライブラリ/フレームワークがPythonには揃っています。

これらのライブラリのおかげで、開発者はゼロからアルゴリズムを実装する手間を省き、既存の実装を組み合わせて効率的に開発を進めることが可能です。

特筆すべきは、Pythonが「グルー言語」(糊のように他の言語で書かれた高速なライブラリを繋ぎ合わせる役割)として機能している点です。

Python自体はインタプリタ言語であり、C++やRustなどのコンパイル言語に比べて実行速度では劣ります。しかし、その弱点を補う形で、多くの数値計算ライブラリや機械学習フレームワークは内部をC/C++やCUDA(OpenGL)などで実装し、Pythonからそれらを呼び出す仕組みになっています。

例えばNumPyの多くの関数はC言語で高速化され、TensorFlowやPyTorchの演算処理はC++やGPU上で実行されます。Pythonはそれらの高性能な低レベル実装を使いやすい高レベルAPIで提供する役割を担っており、ユーザーはPythonのシンプルなコードを書くだけで、実際にはネイティブコード並みの性能を引き出すことができます。これにより、開発のしやすさと実行時の効率を両立しているのがPythonエコシステムの強みです。

さらに、Pythonのコミュニティとサポートも大きな利点です。世界中に広がる開発者コミュニティによって、膨大なチュートリアルやドキュメント、Q&Aサイトでの情報が蓄積されています。困ったときに調べれば大抵の問題は既に誰かが解決策を共有しており、最新の研究手法や実装も素早くライブラリ化されオープンソースで公開されます。こうしたコミュニティの厚みが、Pythonを使ったAI開発の学習コストを下げ、継続的な発展を支えています。

事実、Tiobe指数などプログラミング言語の人気指標でもPythonは常に上位(2020年代には1位)を占めており、幅広い分野で受け入れられていることが分かります。総じて、「書きやすく、支援が多く、すぐ動かせる」という点がPythonをAI開発者にとって魅力的な選択肢としているのです。

最新のAI向けPythonライブラリ・フレームワーク

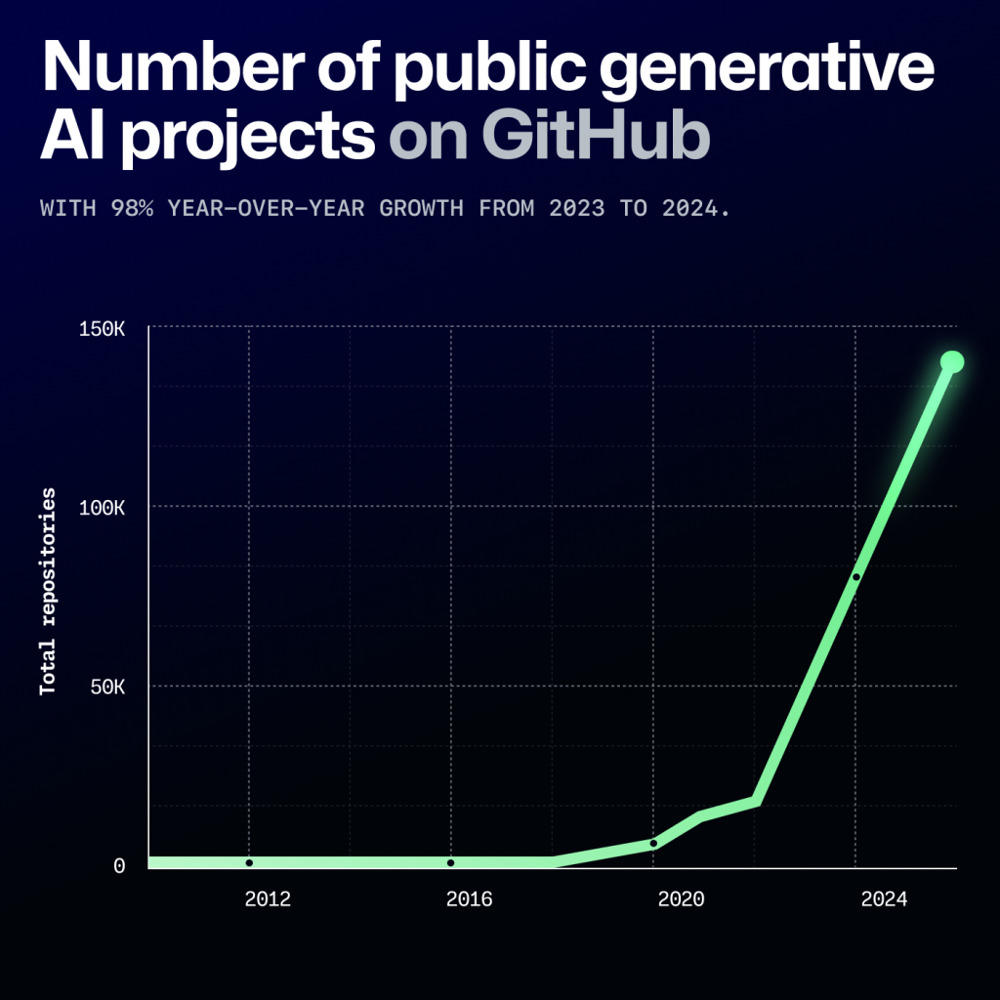

近年のAI分野におけるPythonエコシステムは、生成AI(Generative AI)ブームによってさらに活性化しています。2023年にはOpenAIのChatGPTを筆頭に大規模言語モデル(LLM)が社会現象となり、それに呼応する形でオープンソースのLLM関連プロジェクトが雨後の筍のように登場しました。GitHub上の生成AIプロジェクト数は2023年から2024年にかけて98%増と急増しており、多くの開発者がこの流れに参加しています。

当然、その多くはPythonで実装・公開されており、言語モデルのトレーニングコードや、対話ボットのアプリケーション実装、AIエージェントの開発フレームワークなどが次々と共有されています。

引用:https://github.blog/news-insights/octoverse/octoverse-2024/

上のグラフはGitHub上の公開Generative AIプロジェクト数の推移を示しています。

2022年以降、生成AI関連のリポジトリ数が爆発的に増えており、2024年には15万件近くに達しました。この爆発的成長は、ChatGPTの登場以降にAIプロジェクトが一般開発者層にも広がったことを示唆しています。Pythonはそうしたプロジェクトの主要実装言語であり、AI技術の民主化を下支えしていると言えるでしょう。

このブームの中で、新しいPythonライブラリやフレームワークも続々と登場しています。例えば、大規模言語モデルを手軽に組み合わせてチャットボットやAIエージェントを構築できるLangChainやLlamaIndexといったフレームワークが2023年に急速に普及しました。LangChainはプロンプト(LLMへの入力)を鎖のように繋いで高度なタスクを実現するライブラリで、2023年にはGitHubで最も成長の早いOSSプロジェクトの一つとなりました(LLMブームを反映)。

またHugging Face Transformersライブラリは引き続き発展を続け、最新のモデル(例: MetaのLlama 2やOpenAIのGPT系モデルへのインターフェース)への対応や最適化が進んでいます。

OpenAIの公式APIライブラリもPython向けに提供されており、わずかなコードでChatGPTやDALL·Eといったモデルをアプリに組み込めるようになりました。これらのツールにより、研究者だけでなく一般の開発者も生成AIを用いたアプリケーションをPythonで素早く構築できるようになっています。

データ処理や機械学習基盤の分野でも、新技術の台頭が見られます。長年データ分析で定番だったpandasに対し、Polarsという新世代のデータフレームライブラリが注目を集めています。PolarsはエンジンをRustで実装することでpandasより高速な並列処理を実現しており、「次世代のDataFrame」として脚光を浴びています。2024年7月にはバージョン1.0がリリースされ、開発体制も整ったことで、大規模データの処理でも実用段階に入りつつあります。

JetBrains社の調査では2023年時点で利用者の10%が既にPolarsを使用しているとの結果も出ており、今後さらにシェアが拡大すると見込まれます。こうした新しいデータ処理基盤の登場は、Pythonが抱える性能面の課題を他言語連携で克服する一例でもあります(詳細は後述)。

一方、従来から広く使われているPyTorchやTensorFlowといった深層学習フレームワークも進化を続けています。PyTorchは2023年に2.0系へとアップデートし、「torch.compile」機能の導入によって動的なモデルでも自動的に最適化コンパイルする仕組みを提供し始めました。

これにより、従来のようにモデル定義と訓練ループをそのままPythonで書きつつも、裏ではグラフ実行に近い速度で処理することが可能になっています。実際、PyTorch開発チームは一部のコードをC++からPythonに書き戻す決断さえしており、これはPythonレベルで開発しやすくしながら性能も確保できる見通しが立ったためです。

このように、主要フレームワーク自身もPythonの開発生産性を維持しつつ性能向上を図る動きを見せています。

まとめると、2024~2025年にかけてのPythonエコシステムは、生成AIブームによる新ライブラリ・新プロジェクトの隆盛と、既存基盤の更なる性能強化という二方面で大きな進展を遂げています。Pythonは最新トレンドを素早く取り込みながら、その開発効率の良さで引き続きAI分野をリードしているのです。

AIプロジェクトでのPython活用事例

Pythonの強力さは、実際の著名なAIプロジェクトでの採用例を見ても明らかです。OpenAIのChatGPTを支える大規模言語モデル(GPT-3.5/GPT-4など)の開発・学習にはPythonが用いられています。OpenAIは2020年時点で既に深層学習フレームワークをPythonベースのPyTorchに統一する決断をしており、その理由として「PyTorchへ切り替えたことで生成モデル研究の試行サイクルが数週間から数日に短縮された」ことを挙げています。

これは、大規模モデルの実験を高速に回す上でPython+PyTorchの組み合わせが極めて生産的であったことを示しています。

ChatGPTの開発では、大量のデータを使ったモデル訓練や微調整が繰り返し行われましたが、Pythonの高い表現力とPyTorchの柔軟なAPIによって、研究者はアイデアをすぐコードに落とし込みテストすることができました。その結果が今日の驚異的な対話AIの実現につながっているのです。また、ChatGPT自体の提供形態(対話サービス)においても、推論サーバやバックエンドの一部にPythonが使われていると推測されます(OpenAI公式のPythonクライアントライブラリも提供されています)。このようにChatGPTは「Pythonで作られた代表的AI」とも言える存在です。

また、Stable Diffusionに代表される画像生成AIプロジェクトでもPythonの力が遺憾なく発揮されました。Stable Diffusionは2022年に公開されたテキストから画像を生成する拡散モデルで、公式実装はPython(PyTorch)で記述されています。公開直後から世界中の開発者がこのモデルを試し、改良し、派生プロジェクトを生み出しましたが、その素地となったのがPython+PyTorchのオープンなコードでした。誰でもPython環境でモデルの重みをダウンロードし、数行のコードで画像生成を実行できたため、わずか数週間で無数の応用ツール(画像編集GUIやWebアプリ、モバイルへの移植など)が登場しました。実際、Hugging Face社の提供する「diffusers」ライブラリを使えば、数行のPythonコードでStable Diffusionモデルから画像生成が可能です。

この手軽さはPythonならではと言え、Stable Diffusionが爆発的に普及した要因の一つでもあります。現在もモデルの改良版や派生モデル(例:Stable Diffusion XL)などがPythonコミュニティから生まれ続けており、生成画像分野の発展を牽引しています。

他にも、AlphaGoやAlphaFold(囲碁AIやタンパク質構造予測AI)といったDeepMind社の画期的プロジェクトでもPythonは主要言語として用いられましたし、Facebook(現Meta)のPyTorchはその名の通り社内のAI研究から生まれたPythonベースのフレームワークです。産業界でも、NetflixのレコメンドシステムやUberの需要予測モデルなど、Pythonで構築された機械学習システムが数多く稼働しています。これら具体例が示すように、最先端のAIプロジェクトの多くがPythonを中核技術として採用しており、その柔軟性と開発効率が実証されています。

Pythonの弱点と他の言語との比較

このようにAI分野で欠かせないPythonですが、万能ではなく弱点も存在します。最大の課題はやはり処理速度と並行処理に関する制約です。Pythonはインタプリタ型で動的型付けの言語であるため、C/C++やRustのようなコンパイル言語に比べて一命令あたりの実行が遅く、CPUバウンドな処理(膨大なループ計算など)は純粋なPythonコードでは非効率です。また、CPython処理系にはGIL(グローバルインタプリタロック)と呼ばれる仕組みがあり、一度に動作できるスレッドが1つに制限されてしまうため、マルチスレッドでCPU並列処理するのが難しいという問題もあります。このため、「速さが要求される部分は極力Pythonの外で書き、Pythonは高水準な指揮を執る」というのが基本戦略となります。

Python単独での実行性能の限界

前述の通り、NumPyや機械学習ライブラリ内部では低レベル言語で性能確保されていますが、言い換えればPython単独では実行性能を出しにくいということでもあります。

Pythonの弱点を補完する他の言語の存

こうしたPythonの弱点を補完・克服する存在として、しばしば他の言語が引き合いに出されます。まず挙がるのがJulia(ジュリア)です。Juliaは科学技術計算向けに設計された比較的新しい言語で、JITコンパイルによってほぼC言語並みの高速実行が可能です。文法はPythonに似て平易でありつつ、高度な最適化や並列計算もサポートしており、「遅いPythonに代わる存在」として期待する声もあります。

Juliaの性能的魅力とエコシステムの未成熟さ

例えば多次元配列計算や微分方程式の解法などでJulia製ライブラリは高い性能を示します。しかし現状では、ライブラリやコミュニティの規模でPythonに大きく遅れを取っているのも事実です。

機械学習用のフレームワーク(Flux.jlなど)は存在するものの、TensorFlowやPyTorchほどの普及には至っていません。実際の開発現場でも、Julia単独でAIシステムを構築する例はまだ稀で、むしろPythonとのインターフェース(PythonからJuliaモジュールを呼び出す仕組みなど)を活用し部分的にJuliaを使うケースが散見されます。

総じて、Juliaは「性能面で魅力的だがエコシステム成熟度でPythonに劣る」ため、ニッチな用途や研究用途で補完的に使われる状況と言えるでしょう。

Rust・C++の性能とAIライブラリの現状

次に注目されるのがRust(ラスト)やC++といったシステムプログラミング言語です。特にRustは近年人気が高まっている言語で、安全性(メモリ管理)と実行性能を両立している点が評価されています。Rust自体はコンパイル言語であり、Pythonより桁違いに高速に動作しますが、AI開発においてはライブラリの未成熟さが課題です。

主要な機械学習ライブラリはPythonやC++向けに作られており、Rust版は公式・非公式のバインディングこそあるものの機能が限られたり最新の研究動向へのキャッチアップが遅れがちです。

結果として、多くの開発者は「Rust単独でゼロから実装する」よりも「Pythonで確立されたライブラリを使う」ことを選択しています。

RustとPythonの共存による性能改善

Rustはその性能と安全性からPythonと共存する形で活躍の場を広げています。例えば前述のPolarsは内部をRustで実装しPythonから呼び出せるようにしたライブラリでしたが、このようにRustでコアロジックを書き、Pythonをインターフェースとするアプローチは他にも増えています。

機械学習の分野でも、推論速度を上げるためにモデルの一部をRustで実装したり、Rustで書かれた高速なデータ処理基盤をPythonから利用する例が出てきています(FacebookのおすすめシステムにおけるRust採用などの事例も報告されています)。つまり、Rustは「性能重視のパーツを受け持ち、Pythonと連携する補完言語」としての役割を果たしつつあります。

PythonエコシステムにおけるC++の役割

C++についても同様で、TensorFlowやPyTorchの核心部分、NumPyの線形代数計算、あるいは各種機械学習アルゴリズムの実装はC++で行い、それらをPythonから呼ぶ形が一般的です。

AIモデルの学習自体はGPU(CUDA)上で行われるためボトルネックはあまり問題になりませんが、前後処理やビジネスロジックで速度が必要な箇所はC++やRustで書いてモジュール化し、全体のフローはPythonで組むというマルチ言語体制がしばしば採用されています。

マルチ言語環境でのPythonの位置づけと役割

以上より、Python単独では弱点となる部分を他の言語が補い合う図式が見えてきます。Pythonは開発効率に優れるため高レベルな設計やユーザーインターフェース部分を担い、JuliaやRust、C++は性能が要求される重たい計算部分を担当する、といった分業が一般化しているのです。実際、「2つの言語(高速言語+スクリプト言語)でシステムを構築する」というスタイルは古くからあり、Python以前にもC言語とPerlやMATLABの組み合わせなどが行われてきました。

Pythonはその現代的な発展形として位置づけられ、他言語との親和性(C/C++拡張やFFI、Pythonバインディングの作りやすさなど)も高いため、マルチ言語環境の中核として機能しています。この柔軟な共存戦略こそが、性能問題を抱えつつもPythonがAI分野で覇権を握り続ける理由でしょう。

PythonはAI開発の中心であり続けられるか?

Pythonはそのシンプルさと強力なエコシステムによって、AI開発において揺るぎない地位を築いてきました。最新の調査でも、データサイエンス領域でPythonが依然として極めて重要な存在であることが強調されています。

Python単独では限界、他言語との協調が重要

もっとも、今後もPythonだけですべてがまかなえるわけではなく、他言語との協調や新技術の導入によって進化していく必要があります。幸いなことに、Pythonコミュニティはその点に積極的です。近年はPython自体の高速化にも取り組みが見られ、Python 3.11以降では処理系の最適化により以前のバージョンよりも大幅な速度向上が実現されています。また、将来的にはGILの除去(並列処理性能の改善)も検討されており、言語レベルでの弱点克服にも期待がかかります。

Mojoなど新言語によるPythonの進化

さらに、Mojoのように「Pythonの文法的親しみやすさとC++並みの実行速度」を両立しようとする新言語も登場しました。

Mojoはまだ発展途上でライブラリ生態系もこれからですが、Pythonの長所を受け継ぎつつ低レベル制御を可能にするアプローチは、今後のAI開発言語の方向性を示唆しています。

当面はAI開発の第一選択肢であり続ける

もっとも、現時点ではPythonに匹敵する総合力を備えた言語は存在せず、当面はPythonがAI開発の第一選択肢であり続けると見られます。既存の膨大なコード資産・ライブラリ資産を活かしながら、必要に応じて他言語と連携して性能や特殊用途に対処できる柔軟性こそがPythonの強みです。企業や研究機関も、すでに確立したPythonベースのワークフローを簡単には手放さないでしょう。

ポリグロット(多言語)環境でのPythonの役割

今後は、Pythonが中心にありつつ、周辺を支える言語・技術が多様化する「ポリグロット(多言語)環境」がさらに一般化すると考えられます。例えば、プロトタイプはPythonで迅速に作成し、クリティカルな部分はRustやC++でモジュール化、数値計算コアにJuliaやGPU言語を採用するといった形です。その意味で、Pythonは今後も**AIエコシステムのハブ(拠点)**として機能し続けるでしょう。技術トレンドが移り変わり、新しいモデルやプラットフォームが登場しても、Pythonは適応力高くそれらを取り込み、開発者にとって扱いやすい形で提供し続けるはずです。

「AI開発といえばPython」という図式は続く

要約すれば、PythonがAI開発界で築いた地位は今なお盤石であり、豊富なライブラリとコミュニティによる支えのもとさらなる発展が期待できます。他の言語との健全な競争や協調を通じて弱点を補いつつ、**「AI開発と言えばPython」**という図式は少なくとも近い将来まで続くでしょう。そしてPython自身も改良と進化を続けることで、新たな時代のニーズに応え続けるに違いありません。

まとめ

PythonがAI開発で最も使われるのは、シンプルな構文、豊富なライブラリ、巨大なコミュニティによるサポートがあるためです。一方で処理速度や並列処理に弱点があり、JuliaやRust、C++など他言語との協調で補完されています。今後もPythonはAIエコシステムの中心的存在として進化を続け、他言語と連携した多言語開発環境のハブとして発展していくでしょう。